本文将详细介绍如何将网站数据实时抓取并导入Excel中,包括所需工具、步骤和注意事项,通过本文的学习,您将能够轻松地将网络数据转化为Excel表格,提高工作效率。

随着互联网的发展,我们时常需要处理大量的网络数据,手动复制粘贴的方式既耗时又容易出错,掌握如何将网站数据实时抓取到Excel中的技巧,对于提高工作效率至关重要,本文将为您详细介绍这一过程的实现方法。

所需工具

1、网络爬虫工具:用于从网站抓取数据,常用的网络爬虫工具有Python的Scrapy框架、Node.js的Axios库等。

2、Excel软件:用于存储和处理数据,Microsoft Excel、OpenOffice Calc等都是不错的选择。

3、数据抓取插件/软件:针对Excel的数据抓取插件或软件,如Import.io、Web Data Extractor等。

详细步骤

方法一:使用网络爬虫工具抓取数据到Excel

1、确定目标网站的数据结构,分析需要抓取的数据字段。

2、选择合适的网络爬虫工具,如Scrapy或Axios,编写爬虫代码。

3、设置爬虫参数,如URL、请求头、数据解析规则等。

4、运行爬虫程序,将抓取的数据保存为CSV或JSON格式。

5、将CSV或JSON文件导入Excel中,进行数据处理和分析。

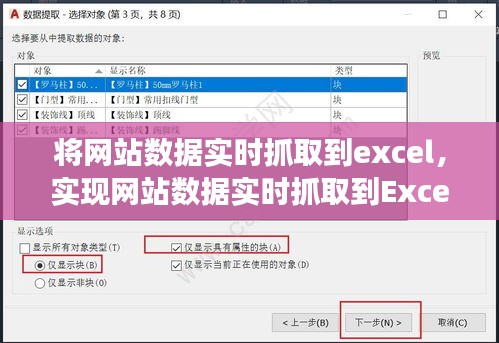

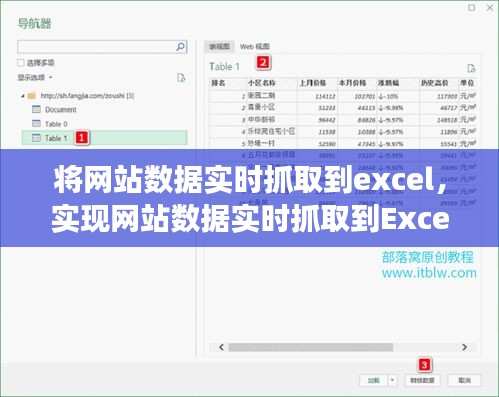

方法二:使用Excel插件/软件抓取数据

1、在Excel中安装并启用数据抓取插件或软件,如Import.io。

2、在插件或软件中设置目标网站的URL和其他参数。

3、选择需要抓取的数据字段,配置数据映射规则。

4、运行数据抓取任务,将抓取的数据导入Excel表格中。

注意事项

1、合法合规:在抓取网站数据时,请确保遵守相关法律法规和网站的爬虫政策。

2、数据质量:在抓取数据时,要注意数据的准确性和完整性,避免引入错误或缺失的数据。

3、数据处理:在将数据导入Excel后,可能需要进行数据清洗和整理工作,以便进行后续分析。

4、技术要求:网络爬虫和数据抓取需要一定的编程和技术基础,初学者可以先从简单的任务开始尝试。

5、更新与维护:随着网站结构的变更,可能需要定期更新爬虫代码或数据抓取配置,以确保数据的实时性和准确性。

本文将网站数据实时抓取到Excel的方法分为两大类:使用网络爬虫工具和使用Excel插件/软件,通过本文的学习,您应该已经掌握了这两种方法的详细步骤和注意事项,在实际工作中,您可以根据具体需求和自身技术水平选择合适的方法,还要不断学习和探索新的工具和方法,以提高工作效率和准确性,希望本文能对您的工作和学习有所帮助,如有任何疑问,欢迎留言讨论。

转载请注明来自重庆贝贝鲜花礼品网,本文标题:《网站数据实时抓取到Excel的高效操作指南》

蜀ICP备2022005971号-1

蜀ICP备2022005971号-1

还没有评论,来说两句吧...